Columnist Glenn Gabe chia sẻ quá trình xử lý sự cố của mình để xác định vấn đề với robots.txt dẫn đến giảm lưu lượng truy cập dài, chậm theo thời gian.

Tôi đã viết nhiều lần trong quá khứ về vấn đề kỹ thuật SEO có thể dẫn đến giảm nghiêm trọng trong bảng xếp hạng và lưu lượng truy cập như thế nào. Để che giấu 404s từ thẻ meta robot đến rel = canonical, một số vấn đề có thể gây thiệt hại nghiêm trọng cho website của bạn, SEO-wise.

Tiếc là tôi đã xem qua trường hợp mới mà tôi sẽ tổng hợp trong bài viết này. Vấn đề đã dẫn đến việc làm chậm bảng xếp hạng và lưu lượng truy cập, làm khó khăn cho các chủ doanh nghiệp. Trước khi công ty biết điều đó, những trang quan trọng đã biến mất khỏi chỉ mục của Google.

Khi nói chuyện với khách hàng về nguy hiểm SEO, tôi thường tổng hợp các tập tin robots.txt. Nó là một tập tin văn bản đơn giản, nhưng nó có thể có một tác động nghiêm trọng về nỗ lực SEO nếu không xử lý một cách chính xác.

Nó làm tôi nhớ đến "busy cricket" từ Người đàn ông trong trang phục màu đen. Tầm vóc nhỏ, nhưng rất mạnh mẽ..

Mặc dù hầu hết các SEO hiểu rằng không cho phép một tấm phủ trong robots.txt sẽ gây ra vấn đề lớn, có rất nhiều tình huống khác cũng có thể gây ra các vấn đề.

Một số có thể xảy ra từ từ và gây ra sự rò rỉ URL từ chỉ mục của Google- và nếu các URL đó là quan trọng, thì bạn sẽ gặp một số vấn đề lớn. (Và bằng cách này, bạn sẽ không biết được trừ khi ai đó thực sự nắm bắt được vấn đề.)

Một công ty tìm đến tôi vào mùa thu này, họ rất lo lắng sau khi nhận ra từ khóa quan trọng của họ đã không còn trong bảng xếp hạng. Nhưng với nhiều thay đổi xảy ra với Google, có phải sự giảm sút trong bảng xếp hạng có thể là bất cứ điều gì? Có lẽ nó là một bản cập nhật thuật toán, có thể cạnh tranh nâng cấp các trò chơi, hoặc chỉ có thể có một vấn đề kỹ thuật gây ra sự sụt giảm trong bảng xếp hạng. Vì vậy, tôi đã thực hiện một số công việc thám tử.

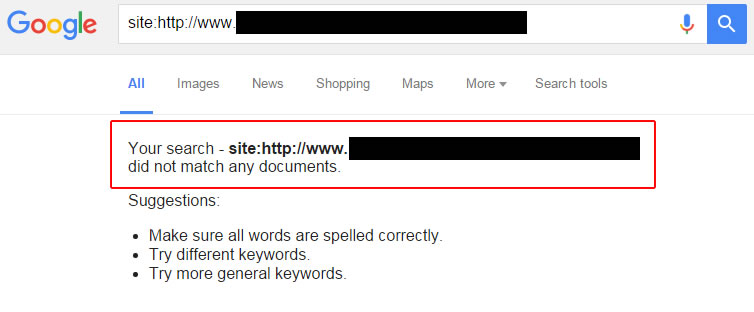

Sau khi đào sâu vào tình hình, tôi nhanh chóng kiểm tra các URL đã được một lần xếp hạng cho các loại từ khóa. Đó là cách để xem một số URL vẫn được xếp hạng, trong khi những người khác không được tìm thấy. Có một số các URL đã biến mất khỏi chỉ mục của Google.

Vì vậy, tôi đã kiểm tra các từ khóa meta robot. Tôi đã kiểm tra tiêu đề x-robot để đảm bảo noindex không được phát hành trong các phản ứng tiêu đề.

Sau đó, tôi đã kiểm tra các URL đều không phải là mô tả, phức tạp và được sử dụng. Về cơ bản, CMS đã không sử dụng các URL "đẹp" cho tỷ lệ phần trăm lớn của các trang trên website ( được thiết lập dựa trên CMS ).

Tôi biết rằng trong những tình huống như thế này, URL dễ dàng nhận ra được bởi chỉ thị của robot.txt tham lam. ("Tham lam" nghĩa là họ có thể ngăn chặn nhiều hơn họ tưởng).

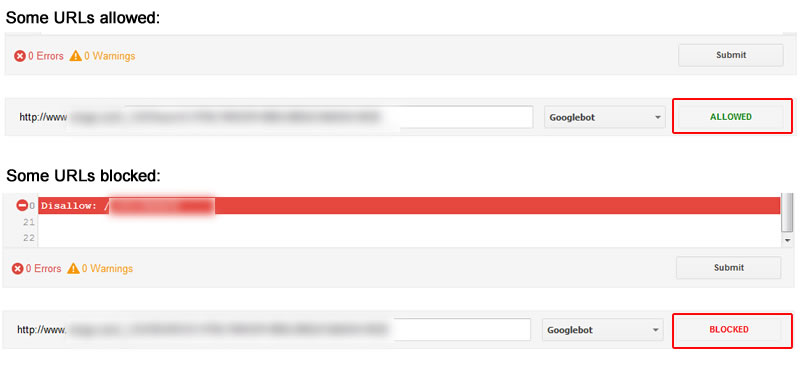

Tôi thấy không hài lòng về robot.txt Tester trong việc tìm kiếm giao diện của Google (GSC) và bắt đầu kiểm tra các URLs. Một vài URLs đã được chặn, trong khi đó một số khác lại được cho phép

Tôi cũng đưa ra một danh sách các URL mà trước đó đã thu thập thông tin và nhận được lưu lượng truy cập từ Google. Điều đó giúp tôi có thể xem bất kỳ URL hiện đang bị chặn bởi robots.txt (số lượng lớn). Một lần nữa, một số đã bị chặn và một số được cho phép. Sau khi phân tích tình hình, nó được chia ra làm hai vấn đề.

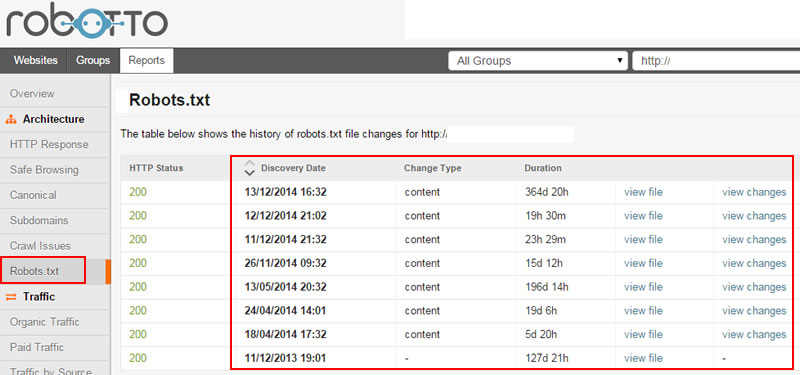

Xem lại các tập tin robots.txt theo thời gian, tôi thấy hai vấn đề chính là đáng lo ngại. Đầu tiên, chỉ thị mới đã được thêm vào robots.txt bởi nhà cung cấp CMS và chủ sở hữu website không có ý tưởng. Các website có hàng chục ngàn URL lập chỉ mục, vì vậy, ngay cả một thay đổi nhỏ trong chỉ thị robots.txt có thể là nguy hiểm.

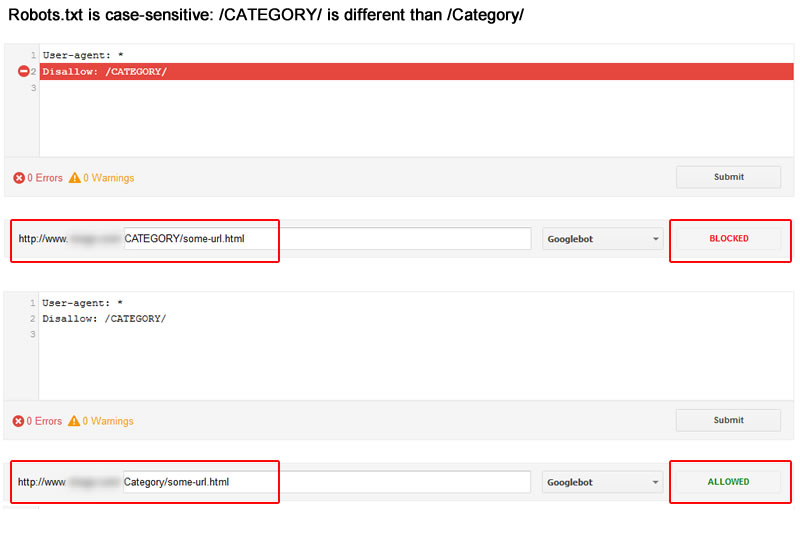

Thứ hai, chỉ thị đã thay đổi một chút. Điều đó có nghĩa là những chỉ thị nhầm lẫn có thể nhận hoặc bỏ lỡ các URL trên website. Ví dụ, nếu bạn nhắm đến thư mục /Category/ nhưng chỉ thị là /CATEGORY/, sau đó bạn sẽ không cho phép các URL giải quyết trong thư mục /Category/, đó cũng giống như nhạy loại chữ. Đó là một điểm quan trọng cần lưu ý cho mọi SEO, webmaster và chủ doanh nghiệp. Xem ảnh chụp màn hình dưới đây.

Giữa các chỉ thị được thêm / xóa theo thời gian và độ nhạy loại chữ thay đổi, công ty đã có URL quan trọng vô tình bị cấm. Khi URL không được phép, Google không thể thu thập dữ liệu trang để xác định các nội dung mà họ có, và điều này làm một số những địa chỉ URL giảm chỉ mục của Google theo thời gian

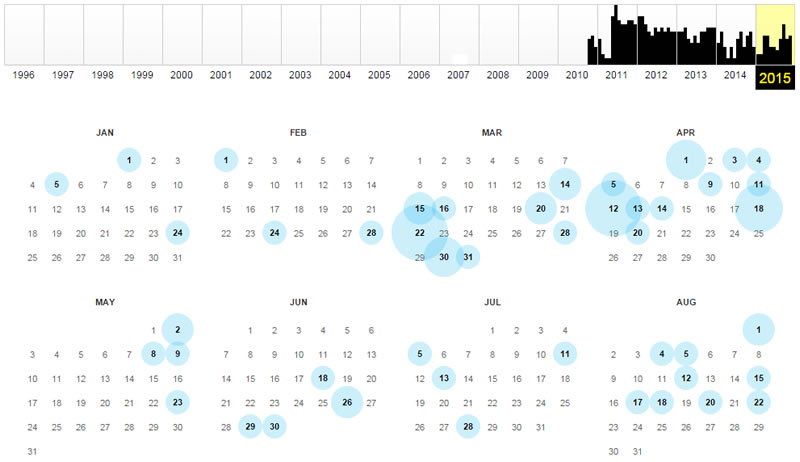

Nhưng đây là khó khăn: URL thường không hạ chỉ mục ngay lập tức - do đó, rất khó khăn để công ty phát hiện. Hiện không có sự giảm sút nào trong một ngày; thay vào đó họ có kinh nghiệm làm rò rỉ chậm URL quan trọng từ chỉ mục của Google. Như bạn có thể đoán, bảng xếp hạng và lưu lượng truy cập bị rò rỉ nhu các URL bị bỏ khỏi các chỉ mục.

Vào tháng 8 năm nay, Google Webmaster Trends Analyst John Mueller ghi lại toàn bộ một hangout webmaster dành riêng cho robots.txt. Đối với những người có liên quan với kỹ thuật SEO phải xem.

John phải giải thích một điều là những URL không được phép được xử lý bởi Google như thế nào, indexation-wise. Ví dụ, URL không được phép vẫn trong chỉ mục, nó sẽ biến mất, mất bao lâu để nó biến mất ?

Tại 32:34 trong video, John giải thích rằng Google sẽ giảm thông tin về URL không được phép từ các lần thu thập trước đó, và nó có thể lập chỉ mục các thông tin cơ bản URL.

Ngoài ra, Google có thể giảm các URL trong danh mục theo thời gian. Không bảo đảm các URL sẽ giảm, nhưng điều đó chắc chắn có thể xảy ra. Xem video tại đây:

Vì vậy, khi có tình huống mà bạn nhầm lẫn việc thu thập dữ liệu từ các URL không được phép, họ có thể vẫn lập chỉ mục trong một thời gian cho đến khi Google quyết định làm giảm chúng. Và cuối cùng khi Google làm giảm, bạn sẽ không có bất kỳ dấu hiệu ( khác hơn là làm giảm lưu lượng truy cập URL ).

Và nếu bạn muốn nghe John nói về nhạy loại chữ, bạn có thể xem 13:50 trong đoạn video. bao gồm một số điểm quan trọng về chỉ thị, nhạy loại chữ

Vậy làm thế nào bạn có thể tránh điều này xảy ra trên website của riêng bạn? Tôi sẽ cung cấp một số đạn dưới đây có thể giúp bạn hiểu khi thay đổi là đang được thực hiện vào tệp robots.txt của bạn và làm thế nào để phát hiện ra nếu URL được sử dụng ưu lượng truy cập đang bị cấm bởi robots.txt.

Điều này không có nghĩa là lời khuyên cuối cùng, nhưng viên đạn dưới đây chắc chắn có thể giúp bạn tránh được thảm họa SEO do các vấn đề robots.txt.

Như bạn thấy với trường hợp này, kỹ thuật SEO thay đổi có thể có một tác động lớn trên bảng xếp hạng và lưu lượng truy cập. Mặc dù robots.txt là một tập tin văn bản đơn giản, các chỉ thị của nó nắm giữ có thể chặn các URL quan trọng từ việc thu thập dữ liệu (mà có thể dẫn đến sự giảm sút những URL từ chỉ mục của Google).

Và nếu những trang bụ giảm từ các chỉ mục, họ không có cơ hội tại bảng xếp hạng. Và không có cơ hội tại bảng xếp hạng, họ không có lưu lượng truy cập. Điều này có nghĩa là bạn thua, trong khi tập tin robots.txt tham lam thắng. Đừng để nó giành chiến thắng. Hãy làm theo lời khuyên của tôi ở trên và tránh rò rỉ URL.